Peut-on vraiment confier la sensibilisation aux grands enjeux humanitaires à des avatars animés par l’intelligence artificielle ? Alors que les crises de réfugiés se multiplient à travers le monde, une initiative du United Nations University Center for Policy Research (UNU-CPR) soulève de nouvelles interrogations sur l’éthique et l’efficacité des outils numériques créés pour représenter les sans-voix.

Deux personnages entièrement fictifs, mais alimentés par l’IA – Amina, une réfugiée imaginaire ayant fui le Soudan, et Abdalla, membre tout aussi fictif des Forces de Soutien Rapide soudanaises – auraient vocation à débattre directement avec les internautes sur une plateforme dédiée (askamina.ai). Mais est-il pertinent de confier la narration de telles réalités à des entités créées de toutes pièces, loin des vécus réels ?

Si certains voient là un pont possible entre le public et le drame humain de l’exil, la démarche du professeur Eduardo Albrecht, responsable du projet et affilié à Columbia et UNU-CPR, intrigue : lui-même affirme qu’il ne s’agit que d’une expérimentation ludique, pas d’un projet officiel proposé aux Nations Unies. Pourtant, le sujet est profondément sérieux. Les utilisateurs parviennent-ils tant que cela à dialoguer avec ces IA, alors que des problèmes techniques empêchent parfois l’accès au service ?

La frontière entre sensibilisation innovante et instrumentalisation des récits soulève des débats éthiques brûlants.

L’étude publiée par les auteurs du projet suggère un usage inattendu : ces avatars pourraient un jour « aider rapidement à convaincre des donateurs ». Mais alors, parle-t-on encore d’information ou bascule-t-on vers la mise en scène émotionnelle au profit de la collecte de fonds ? Et comment expliquer le malaise généralisé de nombreux participants lors d’ateliers-pilotes, qui rappellent avec force que « les réfugiés peuvent très bien s’exprimer par eux-mêmes dans la vie réelle » ?

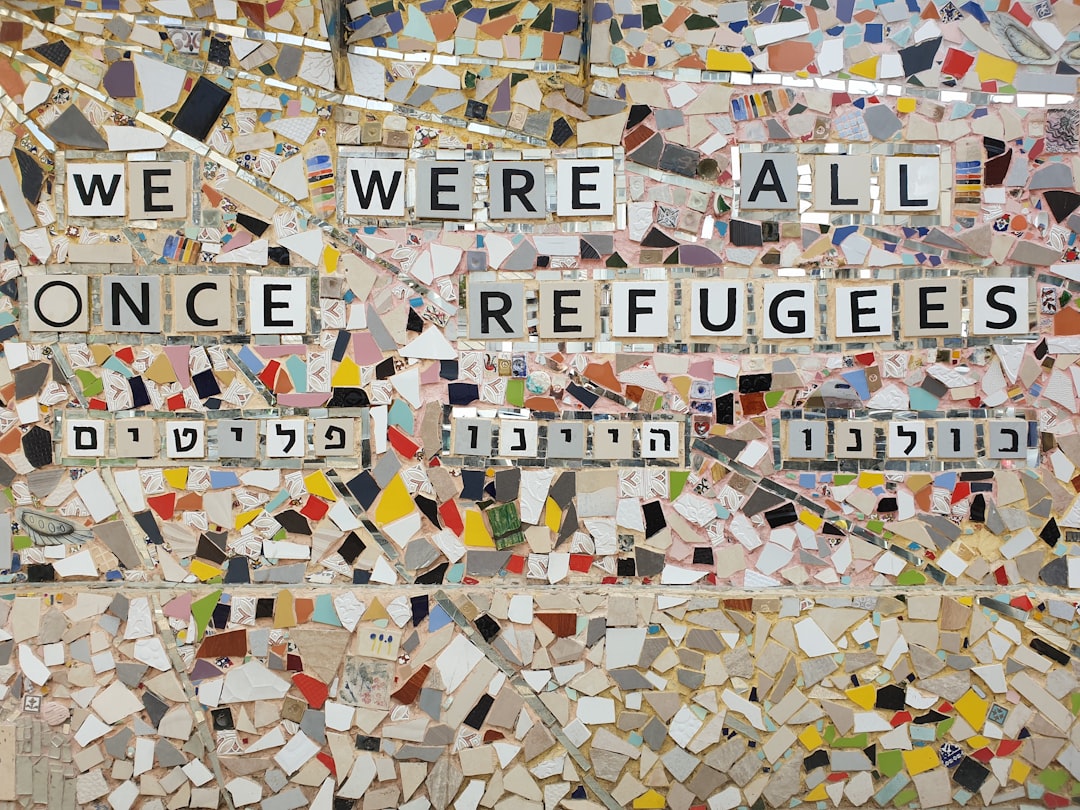

Cette controverse n’est pas qu’une question de technologie. Elle touche à la dignité de la représentation et à la légitimité de donner voix à ceux qui vivent l’exil au quotidien. Est-il acceptable de laisser des IA rédiger les paroles ou les souvenirs d’expériences qui, en réalité, ne leur appartiennent pas ?

À l’heure où les ONG et les institutions cherchent de nouveaux moyens pour toucher l’opinion publique et mobiliser les financements, la tendance à remplacer les témoignages authentiques par des conversations programmées pose une vraie menace : le risque d’évacuer l’humanité au profit d’une interactivité froide et désincarnée.

La technologie peut-elle vraiment transmettre la complexité, la souffrance ou l’espoir de ceux qui ont tout perdu ? Ou bien, à force de vouloir innover, risque-t-on d’effacer la réalité des réfugiés au profit de simulations, aussi bien faites soient-elles ?

Source : Techcrunch