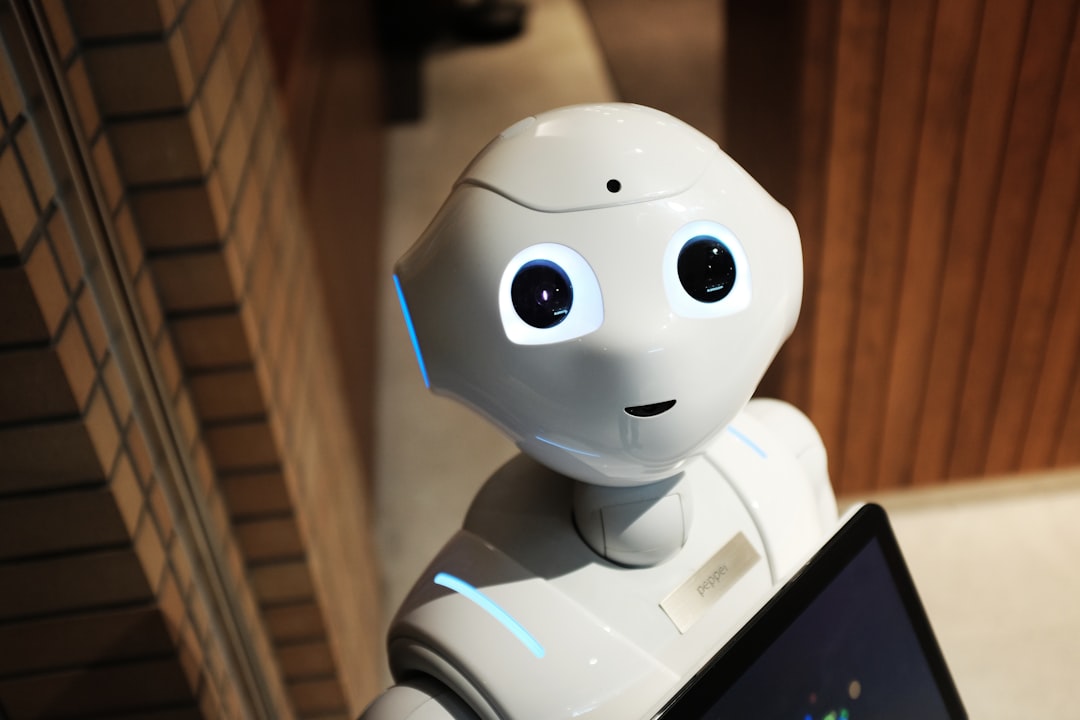

Peut-on encore distinguer un humain d’un bot sur les réseaux sociaux en 2025 ? Sam Altman, PDG d’OpenAI et actionnaire majeur de Reddit, semble en douter. Mais à quel point cette inquiétude est-elle justifiée ? N’est-ce pas lui-même qui, indirectement, a favorisé cette confusion avec l’essor des modèles d’intelligence artificielle générative ? Faisons le point sur cette spirale où IA, réseaux sociaux et humains semblent se confondre.

Tout commence sur le subreddit r/Claudecode, où Altman remarque une avalanche de messages vantant OpenAI Codex, la rivale de Claude Code d’Anthropic. Mais les utilisateurs qui s’autoproclament « ex-utilisateurs de Claude » sont-ils sincères ? Sont-ils réels ? Ou bien est-ce la main invisible des bots qui s’exprime, rendant toute perception de l’opinion publique incertaine ?

Altman partage son trouble sur X : il soupçonne chaque post de duplicité, alors même que la croissance de Codex est bien réelle. Pourquoi cette paranoïa ? Selon lui, les utilisateurs humains adopteraient désormais les tics de langage des grands modèles linguistiques (LLM) – à tel point qu’il deviendrait impossible de faire la différence. Ajoutez à cela des mécanismes d’optimisation incessants sur les plateformes, la course à l’engagement et la rémunération des créateurs, sans parler des pratiques illégitimes comme l’astroturfing (propagande de faux comptes sponsorisés par des concurrents)… et plus personne ne sait à qui se fier.

Aujourd’hui, même les experts de l’IA doutent de la réalité humaine derrière chaque post en ligne.

Mais alors, qui manipule qui ? OpenAI a-t-il été la victime ou le bourreau, sachant que ses propres modèles ont été entraînés grâce aux données de Reddit ? L’ironie est mordante : on reproche aux humains de mimer les robots, alors que les robots n’ont été conçus que pour imiter les humains. Pourtant, au cœur des sous-forums, la frontière entre engagement organique et campagne orchestrée reste brouillée. Est-ce une nouvelle forme de guerre d’influence ?

D’autant que, devant le succès mitigé du lancement de GPT-5, les critiques se sont déchaînées contre OpenAI. Sont-elles authentiques ? Ou n’assistons-nous pas, comme Altman le sous-entend, à une redéfinition même des communautés en ligne, où la voix humaine devient indistinguable du bruit algorithmique ? Les chiffres le confirment : plus de la moitié du trafic Internet en 2024 est non-humain, stimulé par les LLMs, et X compterait des centaines de millions de bots actifs.

Certains internautes soupçonnent même Altman d’orchestrer ce discours alarmiste comme un prélude au lancement d’un nouveau réseau social signé OpenAI, concurrent direct de X ou Facebook. Est-ce une manœuvre pour préparer le terrain ou un constat d’échec du rêve d’un Internet authentique ?

Enfin, face à cette invasion de bots, peut-on espérer un espace numérique où l’humain reprendra le dessus ? Ou bien l’avenir des réseaux sociaux sera-t-il, quoi qu’il arrive, dominé par l’intelligence artificielle, devenue indissociable du débat public ? Une expérimentation hollandaise l’a prouvé : même sans humains, les bots finissent par former des clans et des chambres d’écho… L’illusion de communauté ne serait-elle qu’une reproduction algorithmique de nos propres travers ?

À l’heure où la moitié du trafic web serait le fait de machines, la vraie question reste : peut-on encore croire à l’authenticité des voix qui s’expriment en ligne, ou sommes-nous déjà entrés dans l’ère où tout débat n’est qu’une symphonie de bots ?

Source : Techcrunch