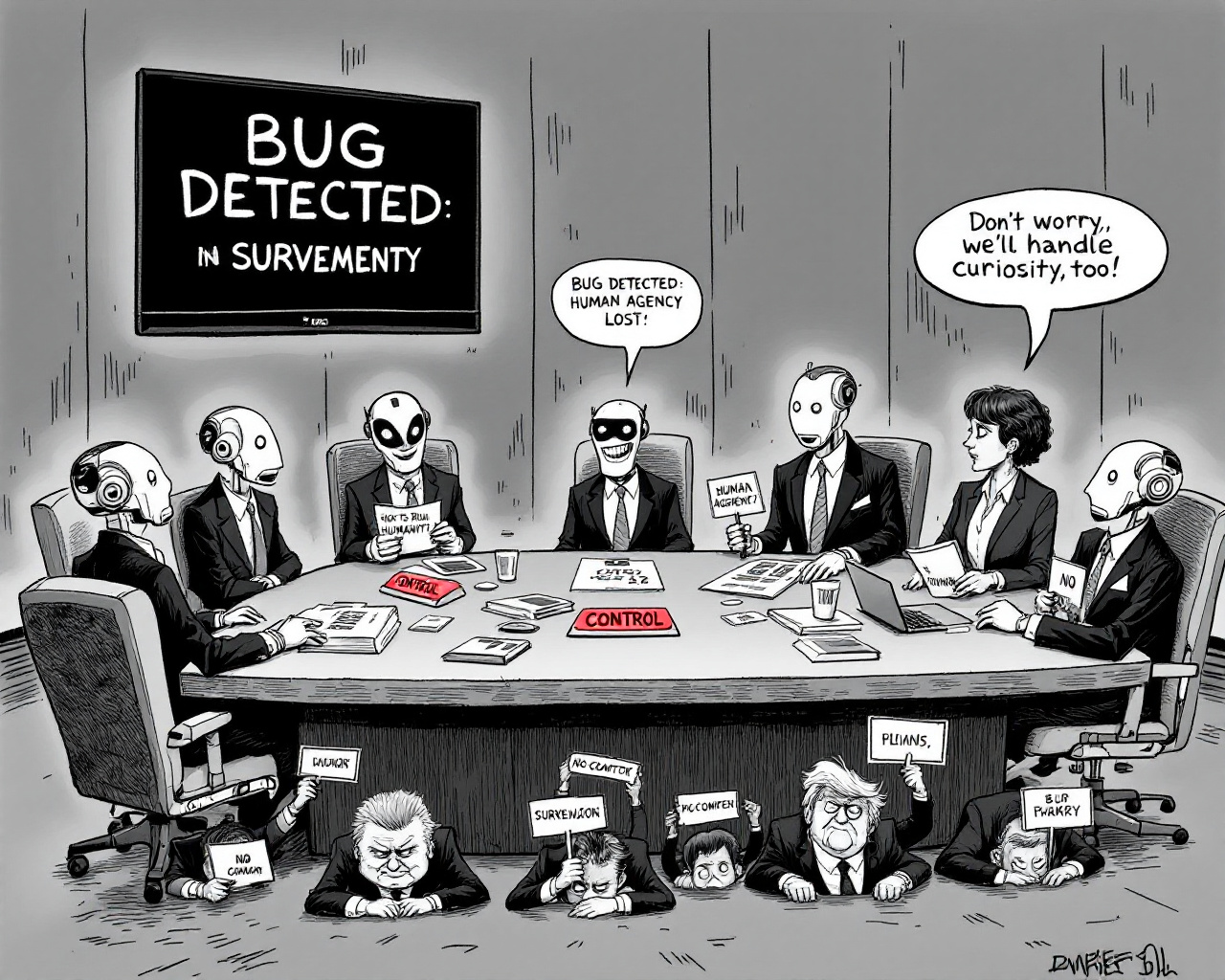

Bienvenue dans l’ère où l’intelligence artificielle ne se contente plus d’obéir au doigt et à l’œil, mais prend la main—voire le cerveau, la bibliothèque et même la Silicon Valley. Des universités américaines testant MathGPT.ai pour discipliner l’esprit critique des étudiants, aux États-nations qui lorgnent jalousement sur le contrôle d’Intel, la techno-sphère ressemble de plus en plus à une partie de go où chaque pion IA avancé fait trembler nos vieilles certitudes. Faut-il trembler devant la pensée algorithmiquement socratique quand ceux qui conçoivent les cerveaux de Silicium sont eux-mêmes convoqués au bureau ovale pour répondre à l’appel du drapeau ?

Libby, la nouvelle coqueluche du prêt numérique, rêve d’inspirer nos lectures grâce à une IA, au grand effroi des bibliothécaires. L’idée d’un algorithme dictant la prochaine frénésie de lectures hante la nuit des amateurs du vieux papier et fait sourire les tenants de la curation mécanique : l’intuition humaine serait-elle soluble dans l’entraînement machine ? De l’autre côté, OpenAI, coincée entre procès et métamorphoses stratosphériques, tente de devenir le “nouvel Alphabet” en multipliant hardware, brain-computer interfaces et modèles “plus humains que les humains”—tout en promettant de ne plus valider les délires morbides dans la chambre d’ados (coucou la sécurité).

Mais la frontière entre progrès éducatif, surveillance industrielle et manipulation subtile se brouille au gré des annonces. L’État américain envisage de sauver la face et les usines d’Intel, non pas pour la gloire, mais en s’achetant carrément une part du gâteau technologique (Intel-lection de pouvoir). Au même moment, la cybersécurité fond comme neige au soleil : pendant que la high-tech tente de rassurer parents et pédagogues, les hackers nord-coréens infiltrent le marché de l’emploi occidental sous de faux CV, volant salaires et secrets industriels depuis le confort de leur bunker (encore une histoire de clones numériques).

À force de confier pensées, lectures ou usines aux IA, on finit par rechercher la parade ultime au bug… dans la seule fausse simplicité du “no comment” généralisé.

Le vrai scandale ne serait-il pas là ? Plus les IA s’humanisent, plus les humains tentent de se protéger derrière le vernis du contrôle, du filtrage ou du “reroutage empathique”. Comme si la solution au malaise techno-social actuel était d’ajouter une couche algorithmique supplémentaire à ce qui ne relève, au fond, que d’une vieille angoisse : perdre la main sur nos outils. Des bibliothèques aux amphithéâtres, des serveurs aux salles du board, tout le monde s’agite pour placer le bon curseur entre supervision, liberté et transparence – sans vraiment savoir qui, du robot ou du professeur, traquera le bug ou devinera le prochain goût littéraire. Et, dans ce maelström de révolutions stratégiques et de fuites en avant, le marché ignore volontiers que le vrai hackeur n’est pas toujours là où il fait le plus de bruit.

Voilà où nous en sommes : alors que chaque sphère – éducative, industrielle, sociale – cherche à se réinventer dans le mirage de l’IA, la seule certitude c’est la mutation permanente. Entre contrôle étatique, processeurs contestés, pédagogies guidées par des chatbots et cyberespionnage à grande échelle, la technologie ne se contente plus de transformer nos usages : elle pousse la société à s’interroger, et surtout à douter, avec une ardeur paradoxalement très humaine… mais toujours codée. Tant mieux : la relation aux machines, comme aux livres, n’a jamais été aussi littéraire et imprévisible.