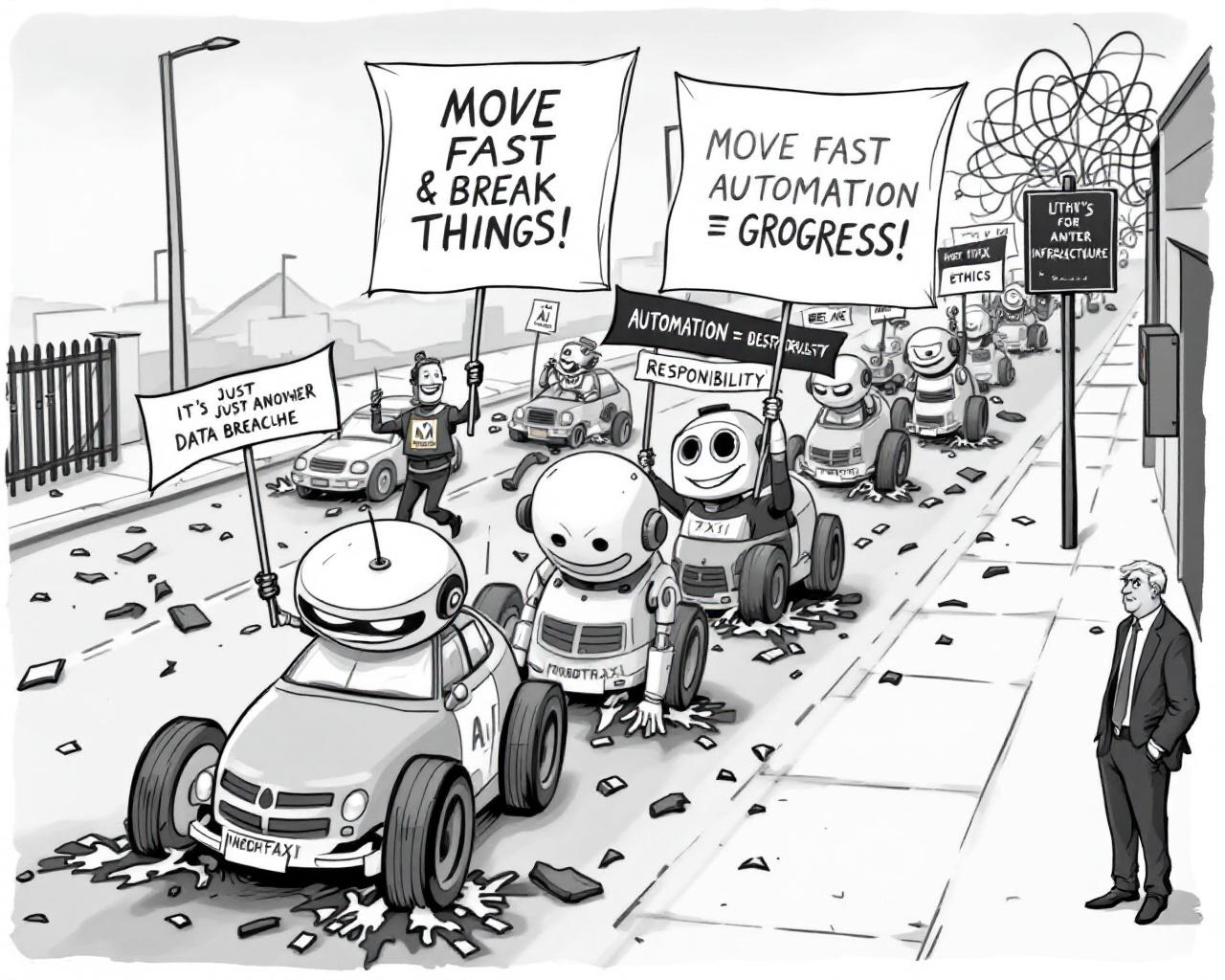

Dans la Silicon Valley, l’innovation avance à coups de slogans (“Move fast and break things”), quitte à oublier, en chemin, que la solidité d’une interface ou la discrétion d’une architecture réseau ne compense pas tout. Quand les compagnies d’assurance fuient leurs responsabilités après des cyberattaques géantes, quand les navigateurs deviennent plus intelligents que leurs concepteurs, et que l’IA aspire notre patrimoine commun à la Wikipédia sans jamais remercier la source, la big tech nous rejoue la scène du “progrès à tout prix”. À l’ère du deep learning et des agents autonomes, l’idée même de confiance numérique tangue comme les robotaxis de San Francisco lors d’une panne d’électricité.

Car chaque innovation majeure, vantée comme la clé d’un monde meilleur (ou d’une navigation web 100% automatisée), charrie son lot de failles et d’aveuglements collectifs. Un agent IA qui réserve votre vol Paris-Pékin sans broncher, certes… mais qui pourrait aussi, distrait par sa propre logique, oublier de vérifier l’authenticité d’un site malveillant qui siphonne vos infos privées. Pendant ce temps, dans les data centers et les bureaux feutrés des assureurs, on relativise : “Ce n’est qu’une fuite de données parmi d’autres !” À l’heure du tout-automatisé, c’est la boucle de rétroaction du scandale — et personne n’écoute les critiques, ni les “User Alignment Critic” censés tenir la boutique éthique de cette technologie galopante.

L’ironie suprême ? L’innovation se gargarise de disruption, mais la gestion de crise est restée bloquée à l’ère PowerPoint : chez Microsoft, on recycle les puces d’OpenAI pour gagner du temps, pendant que l’Amérique s’endort sur ses lauriers et laisse la Chine lui piquer la vedette de l’innovation IA collaborative. À force de verrouiller la recherche et de sous-traiter la sécurité, on arrive à une situation où la production du savoir — de la page Wikipédia pompée en catimini à la puce de calcul vendue en marque blanche — finit par échapper même à ses créateurs. Le progrès, jadis promesse d’autonomie éclairée, devient simple gestion du risque… et inventaire de “fails” annoncés.

Quand tout le monde s’obstine à automatiser l’avenir, le vrai bug reste bien humain : une incapacité chronique à synchroniser puissance, partage et confiance.

Et tandis que la ville des pionniers, San Francisco, découvre que les robotaxis sont surtout de nouveaux plots de stationnement lors d’une coupure, on peut s’étonner : l’autonomie, vantée à chaque keynote, n’est qu’une jolie illusion tant que les infrastructures — réseau, éthique, responsabilité collective — restent précaires ou cadenassées. Même Wikipédia, laboratoire en open source, tente de pactiser avec l’IA tout en surveillant du coin de l’œil la fuite inexorable de ses contributeurs humains : la traçabilité, la reconnaissance, l’incitation à “revenir à la source” sont déjà des vestiges que la prochaine vague pourrait bien submerger sans procès. Existe-t-il encore une place pour la confiance brute et le progrès partagé, alors qu’agents, bots et plateformes accumulent lignes de défense et écran de fumée ?

Il serait temps que la technologie — des compagnies d’assurance jusqu’aux microprocesseurs — se dote d’une vertu rare : la lucidité. Se demander non pas seulement si l’on peut aller plus vite ou automatiser plus loin, mais ce qu’il restera de notre société si chaque bug, chaque panne ou chaque fuite n’est plus qu’un nouveau type d’expérience utilisateur. Puisque l’intelligence artificielle n’est que le miroir déformant de nos contradictions, n’attendons pas qu’une panne géante ou la disparition du bénévolat numérique soit notre prochain signal d’alarme. Dans le grand jeu des innovations, la partie la plus risquée n’est jamais celle où la machine bugge, mais celle où l’humain abdique toute vigilance dans la promesse du “toujours plus”.